Edge computing evolueert al twee decennia lang

Door stijgende vraag naar snel, betrouwbaar en veilig dataverkeer

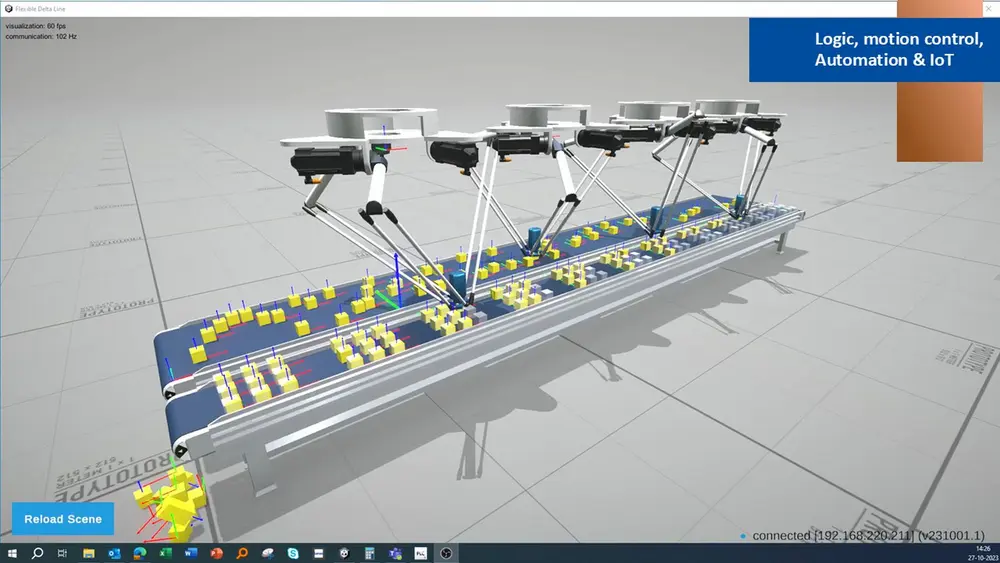

(foto: Phoenix Contact)

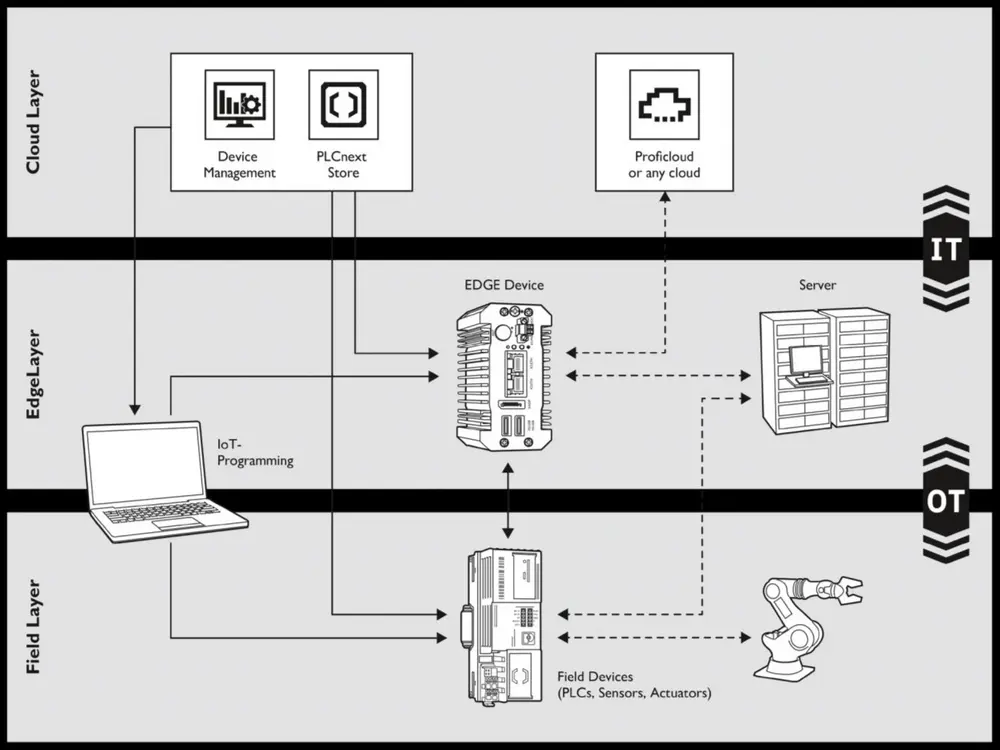

Binnen de procesindustrie biedt edge computing diverse mogelijkheden om de operationele efficiëntie en betrouwbaarheid van de productieprocessen te verbeteren, met als belangrijkste realtime procesbewaking, predictive maintenance en efficiënt energiebeheer. Lokale gegevensopslag en analyse ter plaatse voorkomen overbodige gegevensuitwisseling via het netwerk en de cloud. Dat is niet alleen van belang voor de gegevensintegriteit, het opent ook de weg naar verdere implementatie van Industrie 4.0-concepten en digitale transformatie.

Concept

Het concept edge computing is rond de eeuwwisseling ontwikkeld als onderdeel van de snelle innovaties op het gebied van netwerk- en communicatietechnologie. Het is (mede) een reactie op de opkomst van IoT-technologie die een snellere en efficiëntere gegevensverwerking noodzakelijk maakte.

De basis van gedecentraliseerde en gedistribueerde computing werd in de jaren negentig gelegd met de opkomst van de zogeheten Content Delivery Networks (CDN’s). Het achterliggende idee – content dichter bij de gebruiker brengen om webpagina’s sneller te laden – vormde later het uitgangspunt voor edge computing.

Architectuurprincipe

Edge computing is geen specifieke technologie of apparaat. Eerder is het een breed scala aan technologieën en toepassingen. Noem edge computing een architectuurprincipe. Gegenereerde gegevens worden daarin niet gestuurd naar een gecentraliseerd datacenter of richting de cloud, maar zo dicht mogelijk verwerkt bij de bron, bijvoorbeeld in een lokaal apparaat of een nabijgelegen server. Dit is behalve efficiënt ook van belang voor de gegevensintegriteit: dat wil zeggen de nauwkeurigheid, volledigheid, en consistentie van data gedurende de levenscyclus.

Belangrijkste voordelen edge computing

Lagere latentie

De latentie is de hoeveelheid tijd die verstrijkt tussen het moment dat een verzoek wordt gedaan, bijvoorbeeld het versturen van een 'dataquery', en het moment dat de gewenste gegevens of respons ook daadwerkelijk beschikbaar zijn. Hoge latentie kan een rem vormen op het functioneren van een systeem, met name als het gaat om toepassingen die afhankelijk zijn van een realtime interactie.

Soorten latentie

• Netwerklatentie: de vertragingstijd tussen het verzenden van een datapakket vanaf de bron en het ontvangen ervan bij de bestemming. Van belang daarbij zijn onder meer afstand, verbindingskwaliteit en netwerkbelasting.

• I/O-latentie: de optredende vertraging bij onder meer het lezen of wegschrijven van data naar een schijf of andere opslagapparaten. Van invloed hierop zijn de snelheid van het opslagmedium en de efficiëntie van het besturingssysteem.

• Verwerkingslatentie: de tijd die de Central Processing Unit (CPU) nodig heeft voor de dataverwerking en het genereren van antwoorden. Een lage verwerkingslatentie is essentieel voor (industriële) toepassingen aangezien die snel moeten kunnen reageren.

Minder bandbreedtegebruik

Het bandbreedtegebruik – de hoeveelheid data die wordt verzonden en ontvangen in een bepaalde tijdspanne – daalt om de eenvoudige reden dat er minder gegevens naar centrale locaties worden gestuurd; die worden lokaal be- en verwerkt. Het verzenden van essentiële gegevens, inzichten en/of samenvattingen volstaat dus. Die gegevensstroom kan continu of discontinu zijn.

Gegenereerde gegevens worden niet gestuurd naar een gecentraliseerd datacenter of richting de cloud, maar zo dicht mogelijk verwerkt bij de bron

Bij een continue gegevensstroom worden data constant en zonder onderbreking verzonden daar waar een constante, vloeiende informatiestroom voor de functionaliteit cruciaal is. Dit is onder meer het geval bij video-analyse of monitoring van machines.

Van een discontinue gegevensstroom is sprake wanneer gegevens slechts dan worden verzonden wanneer er nieuwe informatie beschikbaar is of wanneer aan bepaalde voorwaarden is voldaan (tijdelijk dan wel trigger-gebaseerd). Daarvan is onder meer sprake bij camera’s, sensoren en alarmen en/of melders.

Hogere snelheid, betere betrouwbaarheid

De hogere snelheid is direct terug te voeren op gegevensverwerking dicht(er) bij de bron. Omdat alleen essentiële gegevens worden doorgestuurd, wordt het netwerk ontlast en komt er bandbreedte vrij. Ook is er minder vertraging en verloopt de data-uitwisseling en -verwerking efficiënter. Dit komt de betrouwbaarheid ten goede, met name in situaties waarin on-the-spot-besluitvorming een vereiste is.

Verminderde afhankelijkheid van de centrale infrastructuur

Door de lokaal aanwezige rekenkracht zijn edge-apparaten minder afhankelijk van constante verbindingen met externe servers. Bij netwerkstoringen zal edge-apparatuur blijven functioneren – cruciaal in het geval van kritieke toepassingen (mission-critical applications). Dit zijn systemen of processen waarbij zelfs korte onderbrekingen of vertragingen ernstige gevolgen kunnen hebben.

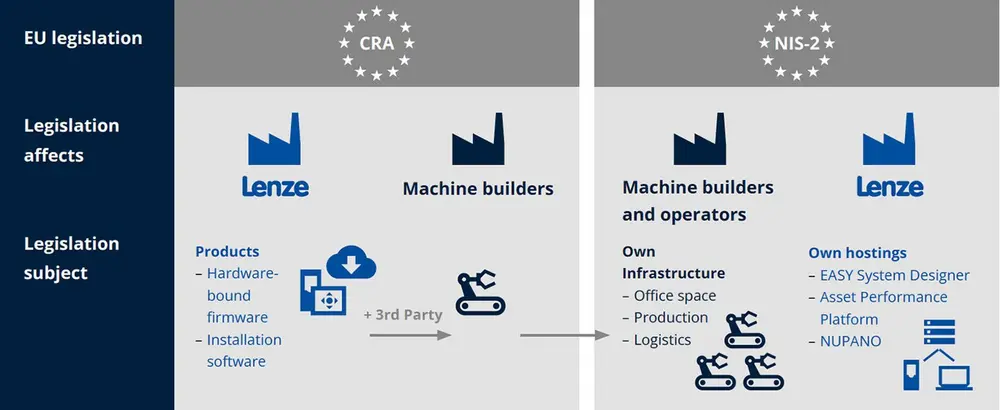

Cybersecurity

Lokale dataverwerking verkleint het risico op verlies of onderschepping, zonder verdere afhankelijkheid van datatransport over openbare netwerken of cloudopslag. Ook kunnen beveiligingscontroles sneller en efficiënter worden uitgevoerd, wat helpt bij de detectie van en het adequaat reageren op potentiële bedreigingen.

Daartegenover staat dat elk edge-apparaat in principe een toegangspoort is voor cyberaanvallen; beveiligingsupdates zijn daardoor vaak slechts beperkt mogelijk. Dit maakt robuuste authenticatie- en toegangscontroles cruciaal evenals endpoint-beveiliging. Doorgaans gebeurt dit in de vorm van 'multifactor-authenticatie' en 'end-to-end-encryptie', zie kader. Eind 2027 breidt de Cyber Resilience Act (CRA) deze verplichting uit naar alle machines en componenten met digitale elementen.

Multifactor-authenticatie versus end-to-end-encryptie

Multifactor-authenticatie (MFA) vereist twee of meer identificatievormen: een wachtwoord of PIN, een beveiligingstoken of smartphone en een vingerafdruk dan wel gezichtsherkenning. Deze extra lagen maken onbevoegde toegang (veel) moeilijker, zelfs wanneer één van de verificatiefactoren wordt gecompromitteerd.

Bij end-to-end-encryptie (E2EE) is een beveiligingsmethode waarbij versleuteling plaatsvindt op het apparaat van de verzendende partij. Behalve de vooraf beoogde persoon kan niemand het bericht ontsleutelen, ook de dienstverlener/provider niet.

Groeiscenario

Gedurende de laatste twee decennia is edge computing snel geëvolueerd. De volgende deelontwikkelingen hebben daar binnen de procesindustrie aan bijgedragen.

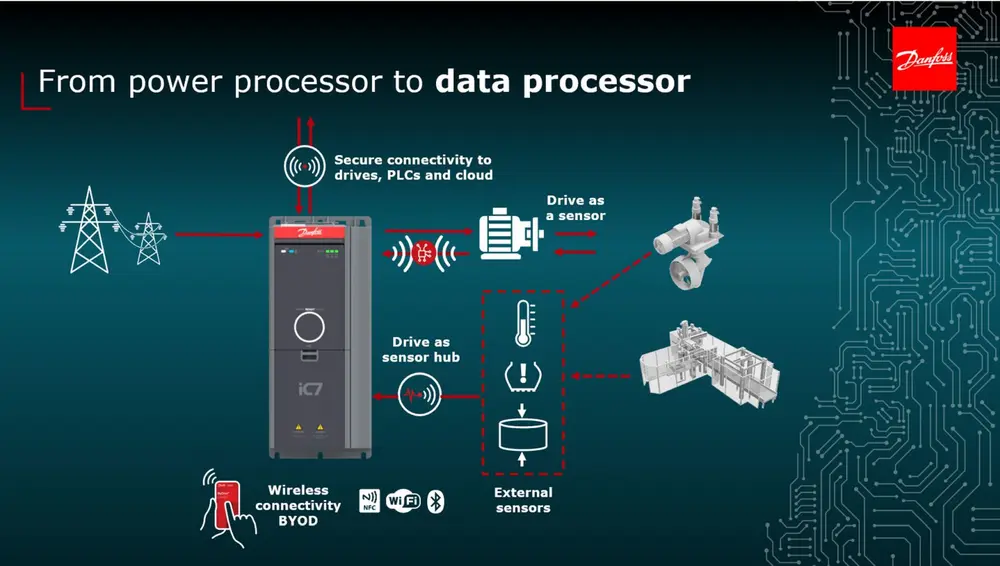

Groei Internet of Things

Internet of Things (IoT) beleefde zijn technische doorbraak aan het begin van deze eeuw, mede dankzij de opkomst van draadloze netwerken, goedkope sensoren en cloud computing. De mogelijkheid om apparaten eenvoudig én betaalbaar met elkaar te verbinden heeft geleid tot een netwerk van fysieke apparaten, sensoren en andere objecten dat in staat is tot realtimegegevensuitwisseling:

- realtime monitoring van productieparameters als druk, temperatuur en flow;

- efficiënt energiebeheer dankzij realtime monitoren en optimalisatie van energiestromen in procesinstallaties;

- kwaliteitscontrole en traceerbaarheid middels IoT-sensoren en RFID-tags die grondstoffen en producten gedurende de gehele productieketen volgen;

- voorraadbeheer en logistiek waarbij slimme IoT-sensoren de voorraden van grondstoffen, half- en eindproducten realtime bijhouden.

Opmars AI en realtime toepassingen

In de procesindustrie speelt de combinatie van AI en realtime toepassingen een steeds grotere rol bij het optimaliseren van productieprocessen en het verhogen van de efficiëntie. Te denken valt daarbij onder meer aan:

- AI-inference – waarbij een getraind AI-model nieuwe gegevens gebruikt om output te genereren – wordt in toenemende mate lokaal door edge-apparaten uitgevoerd. Dit resulteert in snellere besluitvorming, lagere latentie en efficiënter gebruik van netwerken en verwerkingscapaciteit;

- voorspellend onderhoud waarbij AI-modellen data van machines en sensoren analyseren, terwijl realtime monitoring operators in staat stelt adequaat in te grijpen;

- procesoptimalisatie waarbij AI dankzij realtime gegevensanalyse productieparameters continu kan optimaliseren wat de kwaliteit en de (kosten)efficiëntie ten goede komt;

- kwaliteitscontrole waarbij AI-algoritmen het mogelijk maken beelden en data realtime te analyseren om aldus defecten en/of afwijkingen op te sporen;

- veiligheid en risicobeheer waarbij AI en realtime data het mogelijk maken de veiligheid in de werkomgeving te monitoren door tijdig potentiële risico’s te signaleren.

Toekomstperspectief

Insiders verwachten dat edge computing zal blijven voorzien in nieuwe mogelijkheden om aan de snel stijgende vraag naar snel, betrouwbaar en beveiligd dataverkeer te (kunnen blijven) voldoen. Enkele voorbeelden.

Decentralisatie van de infrastructuur

Er is sprake van een toenemend gebruik van gedistribueerde netwerken van edge-apparaten met als groot voordeel dat bij uitval van één apparaat of locatie de rest van het systeem zonder problemen blijft functioneren.

Lokale dataverwerking verkleint het risico op verlies of onderschepping, zonder verdere afhankelijkheid van datatransport over openbare netwerken of cloudopslag

Edge-cloud hybride modellen

Hierbij is er sprake van een toenemende synergie tussen edge computing en centrale verwerking in de cloud. De schaalvoordelen van de cloud worden gecombineerd met de snelheid en responsiviteit van edge computing, zodat data efficiënter, sneller en flexibeler wordt verwerkt.

Integratie edge computing en IoT-apparaten

Edge computing raakt steeds nauwer verweven met IoT-infrastructuren, waarbij gegevensverwerking, filtering en AI-inference direct op edge-nodes of embedded apparaten plaatsvindt. Daardoor vermindert de latentie en verbeteren de reactietijden wat vooral van belang is bij realtime toepassingen.

Multi-access Edge Computing (MEC)

Hierbij worden rekenkracht, opslag en applicaties dichtbij de gebruikers geplaatst, vaak aan de rand van mobiele netwerken om vertraging te minimaliseren en prestaties te verbeteren. De combinatie '5G - edge-computing' levert realtime prestaties die cruciaal zijn voor kritieke toepassingen.

TinyML en microcontroller-gebaseerde AI

Tiny Machine Learning (TinyML) is het toepassen van machine learning op energiezuinige, kleine apparaten, bijvoorbeeld microcontrollers. Toevoeging van kunstmatige intelligentie aan embedded hardware met beperkte rekenkracht maakt deze slimmer zonder extra infrastructuur of cloudkosten.

Kortom: edge computing opent de weg naar meer realtime toepassingen in de (proces)industrie, maar zeker niet alleen daar.

Met medewerking van Danfoss, Emerson, Lenze en Phoenix Contact