L'edge computing évolue rapidement depuis deux décennies

En raison de la demande croissante d'un trafic de données rapide, fiable et sécurisé

(photo: Phoenix Contact)

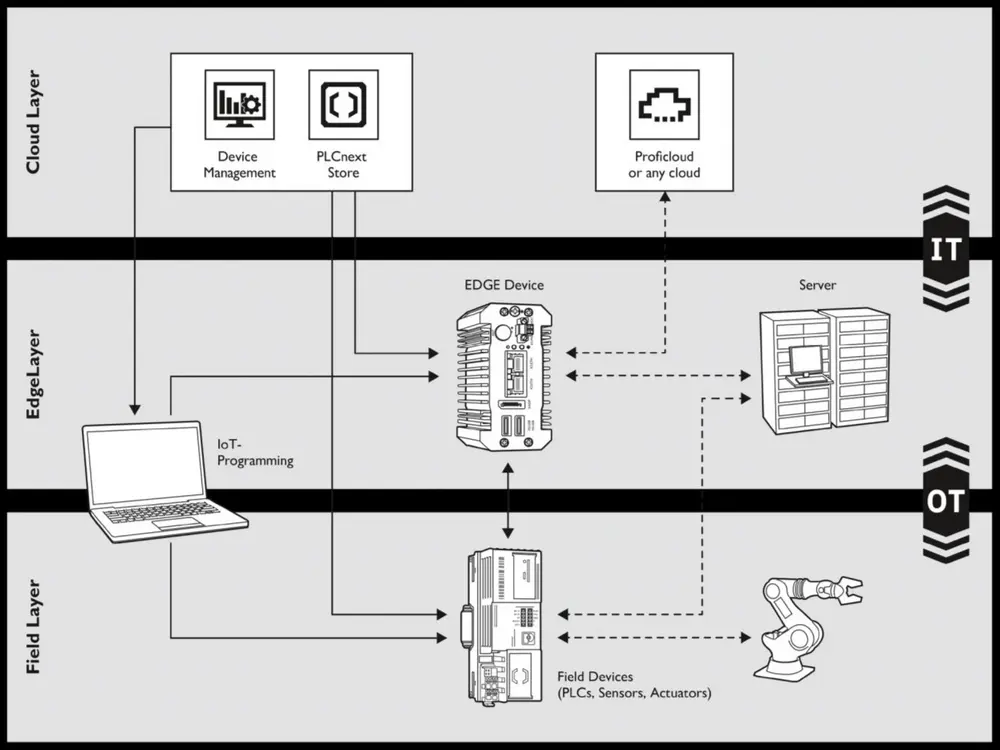

Dans l'industrie de transformation, l'informatique de pointe offre plusieurs possibilités d'améliorer l'efficacité opérationnelle et la fiabilité des processus de production, en particulier la surveillance des processus en temps réel, la maintenance prédictive et la gestion efficace de l'énergie. Le stockage local des données et l'analyse sur site évitent l'échange redondant de données sur le réseau et dans le cloud. Cela n'est pas seulement important pour l'intégrité des données, mais ouvre également la voie à une mise en œuvre plus poussée des concepts de l'industrie 4.0 et de la transformation numérique.

Le concept

Le concept d'edge computing a été développé au tournant du siècle dans le cadre des innovations rapides des technologies de réseau et de communication. Il s'agit (en partie) d'une réponse à l'émergence de la technologie IoT qui nécessitait un traitement des données plus rapide et plus efficace.

Les fondements de l'informatique décentralisée et distribuée ont été posés dans les années 1990 avec l'émergence des réseaux de diffusion de contenu (CDN). L'idée sous-jacente - rapprocher le contenu de l'utilisateur pour charger les pages web plus rapidement - a ensuite constitué le point de départ de l'edge computing.

Principe d'architecture

L'edge computing n'est pas une technologie ou un dispositif spécifique. Il s'agit plutôt d'un large éventail de technologies et d'applications. L'informatique de pointe est un principe architectural. Les données générées ne sont pas envoyées vers un centre de données centralisé ou vers le cloud, mais traitées le plus près possible de la source, par exemple dans un appareil local ou un serveur proche. Outre l'efficacité, ce principe est également important pour l'intégrité des données, c'est-à-dire l'exactitude, l'exhaustivité et la cohérence des données tout au long de leur cycle de vie.

Principaux avantages de l'informatique en périphérie

Temps de latence réduit

La latence est le temps qui s'écoule entre le moment où une demande est faite, par exemple en envoyant une 'requête de données', et le moment où les données ou la réponse souhaitées sont effectivement disponibles. Une latence élevée peut entraver le fonctionnement d'un système, en particulier pour les applications qui reposent sur une interaction en temps réel.

Types de latence

- Latence du réseau: délai entre l'envoi d'un paquet de données depuis la source et sa réception à la destination. La distance, la qualité de la connexion et la charge du réseau sont des facteurs importants.

- Latence E/S: le délai qui se produit lors de la lecture ou de l'écriture de données sur un disque ou d'autres dispositifs de stockage, entre autres. La vitesse du support de stockage et l'efficacité du système d'exploitation ont une influence.

- Latence de traitement: le temps nécessaire à l'unité centrale de traitement (CPU) pour traiter les données et générer des réponses. Une faible latence de traitement est essentielle pour les applications (industrielles) qui doivent pouvoir réagir rapidement.

Moins d'utilisation de la bande passante

L'utilisation de la bande passante - la quantité de données envoyées et reçues dans un laps de temps donné - diminue pour la simple raison que moins de données sont envoyées vers des sites centraux; elles sont traitées localement. L'envoi de données essentielles, d'informations et/ou de résumés suffit. Ce flux de données peut être continu ou discontinu.

Les données générées ne sont pas envoyées vers un centre de données centralisé ou vers le cloud, mais traitées le plus près possible de la source

Dans le cas d'un flux de données continu, les données sont envoyées en permanence et sans interruption lorsqu'un flux d'informations constant et régulier est crucial pour la fonctionnalité. C'est le cas, par exemple, de l'analyse vidéo ou de la surveillance des machines.

Dans le cas d'un flux de données discontinu, les données ne sont envoyées que lorsque de nouvelles informations sont disponibles ou lorsque certaines conditions sont remplies (temporaires ou basées sur des déclencheurs). Il s'agit notamment de caméras, de capteurs et d'alarmes et/ou de détecteurs.

Vitesse plus élevée, meilleure fiabilité

La vitesse accrue est directement attribuable au traitement des données à proximité de la source. Comme seules les données essentielles sont transmises, le réseau est soulagé et la bande passante est libérée. Il y a également moins de retard et l'échange et le traitement des données sont plus efficaces. La fiabilité s'en trouve améliorée, en particulier dans les situations où il est nécessaire de prendre des décisions sur-le-champ.

Dépendance réduite à l'égard de l'infrastructure centrale

La puissance de calcul étant disponible localement, les appareils périphériques sont moins dépendants des connexions constantes à des serveurs distants. En cas de défaillance du réseau, les appareils périphériques continueront à fonctionner, ce qui est crucial dans le cas d'applicationscritiques. Il s'agit de systèmes ou de processus pour lesquels des interruptions ou des retards, même brefs, peuvent avoir de graves conséquences.

Cybersécurité

Le traitement local des données réduit le risque de perte ou d'interception, sans qu'il soit nécessaire de recourir au transport des données sur des réseaux publics ou au stockage dans le cloud. Les contrôles de sécurité peuvent également être effectués plus rapidement et plus efficacement, ce qui permet de détecter les menaces potentielles et d'y répondre de manière appropriée.

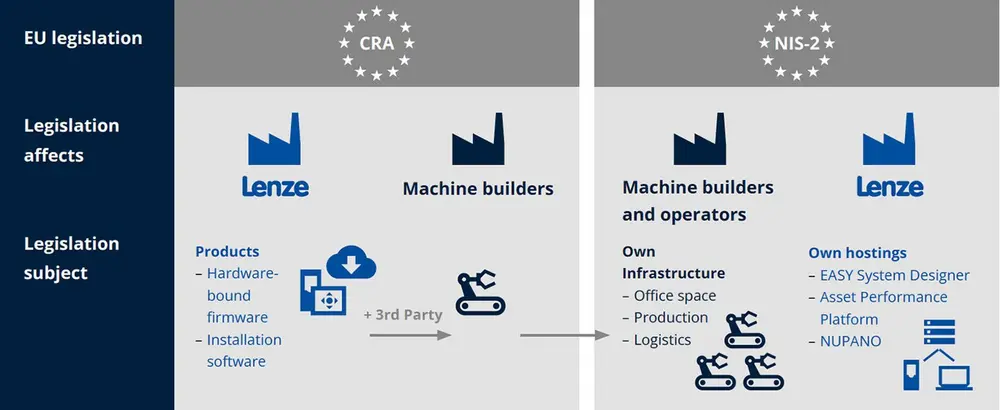

D'un autre côté, chaque appareil périphérique est essentiellement une passerelle pour les cyberattaques; les mises à jour de sécurité sont donc souvent limitées. Il est donc essentiel de disposer d'une authentification et de contrôles d'accès robustes, ainsi que d'une sécurité des points d'extrémité. En général, cela prend la forme d'une "authentification multifactorielle" et d'un "chiffrement de bout en bout" (voir encadré). D'ici à la fin de 2027, la loi sur la cyber-résilience (CRA) étend cette obligation à toutes les machines et à tous les composants comportant des éléments numériques.

Authentification multifactorielle et chiffrement de bout en bout

L'authentification multifactorielle (MFA) nécessite au moins deux formes d'identification: un mot de passe ou un code PIN, un jeton de sécurité ou un smartphone, et une empreinte digitale ou une reconnaissance faciale. Ces couches supplémentaires rendent l'accès non autorisé (beaucoup) plus difficile, même si l'un des facteurs d'authentification est compromis.

Le chiffrement de bout en bout (E2EE) est une méthode de sécurité dans laquelle le chiffrement a lieu sur l'appareil de l'expéditeur. En dehors de la personne visée, personne ne peut décrypter le message, y compris le fournisseur de services.

Scénario de croissance

Au cours des deux dernières décennies, l'informatique en périphérie a évolué rapidement. Les sous-développements suivants y ont contribué dans l'industrie des procédés.

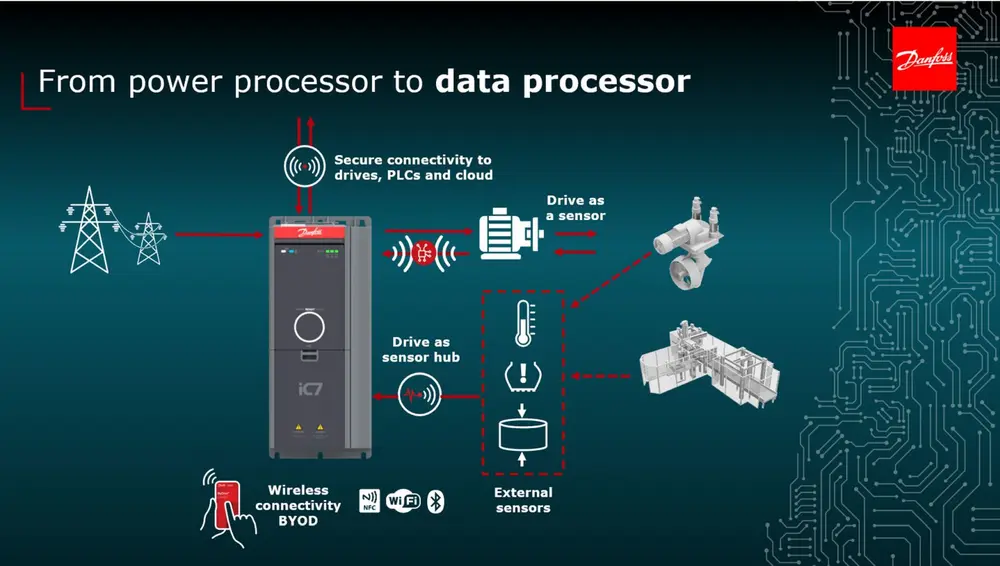

Croissance de l'internet des objets

L'internet des objets (IdO) a connu sa percée technique au début de ce siècle, en partie grâce à l'émergence des réseaux sans fil, des capteurs à faible coût et de l'informatique dans le cloud. La possibilité de connecter des appareils facilement et à un prix abordable a donné naissance à un réseau d'appareils physiques, de capteurs et d'autres objets capables d'échanger des données en temps réel:

- la surveillance en temps réel des paramètres de production tels que la pression, la température et le débit;

- gestion efficace de l'énergie grâce à la surveillance en temps réel et à l'optimisation des flux d'énergie dans les installations de traitement;

- le contrôle de la qualité et la traçabilité grâce aux capteurs IoT et aux étiquettes RFID qui suivent les matières premières et les produits tout au long de la chaîne de production;

- la gestion des stocks et la logistique où des capteurs IoT intelligents suivent en temps réel les stocks de matières premières, de produits semi-finis et finis.

Essor de l'IA et des applications en temps réel

Dans l'industrie de transformation, la combinaison de l'IA et des applications en temps réel joue un rôle croissant dans l'optimisation des processus de production et l'augmentation de l'efficacité. Voici quelques exemples:

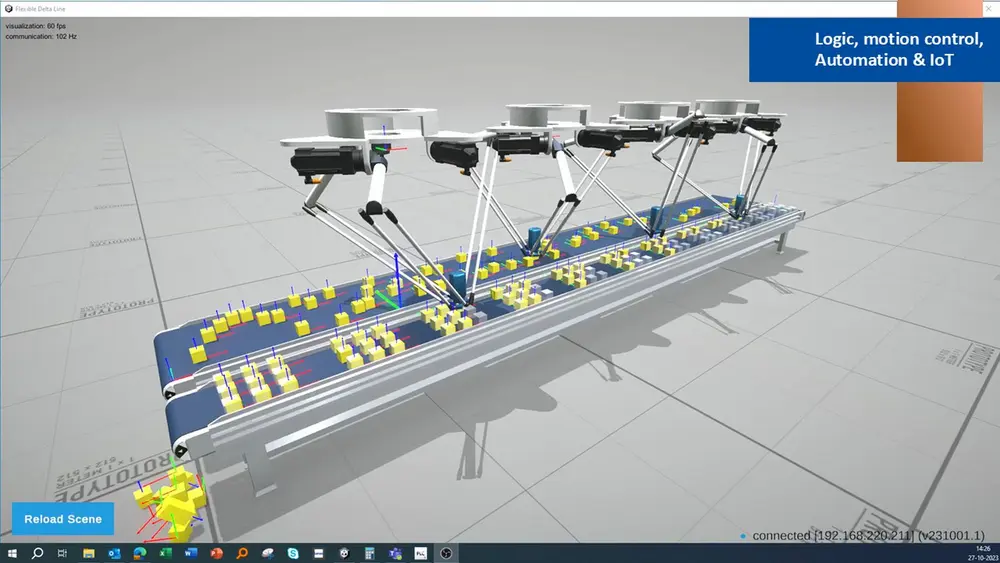

- L'inférence de l'IA - où un modèle d'IA formé utilise de nouvelles données pour générer des résultats - est de plus en plus souvent effectuée localement par des dispositifs périphériques. Cela se traduit par une prise de décision plus rapide, une latence plus faible et une utilisation plus efficace des réseaux et de la capacité de traitement;

- la maintenance prédictive, où les modèles d'IA analysent les données des machines et des capteurs, tandis que la surveillance en temps réel permet aux opérateurs d'intervenir de manière appropriée;

- l'optimisation des processus, où l'IA peut optimiser en permanence les paramètres de production grâce à l'analyse des données en temps réel, ce qui améliore la qualité et la rentabilité;

- le contrôle de la qualité, où les algorithmes d'IA permettent d'analyser en temps réel les images et les données afin de détecter les défauts et/ou les déviations;

- la gestion de la sécurité et des risques, où l'IA et les données en temps réel permettent de contrôler la sécurité dans l'environnement de travail en identifiant à temps les risques potentiels.

Perspectives d'avenir

Les initiés s'attendent à ce que l'informatique en périphérie continue à offrir de nouvelles opportunités pour (continuer à) répondre à la demande croissante de trafic de données rapide, fiable et sécurisé. Quelques exemples.

Décentralisation de l'infrastructure

Les réseaux distribués de dispositifs périphériques sont de plus en plus utilisés, avec le grand avantage qu'en cas de défaillance d'un dispositif ou d'un emplacement, le reste du système continue de fonctionner sans problème.

Le traitement local des données réduit le risque de perte ou d'interception, sans qu'il soit nécessaire de recourir au transport des données sur les réseaux publics ou au stockage dans le cloud

Modèles hybrides "Edge-cloud

Dans ce cas, il existe une synergie croissante entre l'informatique en périphérie et le traitement central dans l'informatique dans le cloud. Les économies d'échelle du cloud sont combinées à la vitesse et à la réactivité de l'edge computing, ce qui permet de traiter les données de manière plus efficace, plus rapide et plus souple.

Intégration de l'informatique de pointe et des appareils IoT

L'edge computing est de plus en plus imbriqué dans les infrastructures IoT, le traitement des données, le filtrage et l'inférence de l'IA s'effectuant directement sur les nœuds de périphérie ou les appareils embarqués. Cela permet de réduire la latence et d'améliorer les temps de réponse, ce qui est particulièrement important dans les applications en temps réel.

Informatique périphérique multi-accès (MEC)

Il s'agit de placer la puissance de calcul, le stockage et les applications à proximité des utilisateurs, souvent à la périphérie des réseaux mobiles, afin de minimiser les temps de latence et d'améliorer les performances. La combinaison "5G - edge computing" offre des performances en temps réel qui sont essentielles pour les applications critiques.

TinyML et l'IA basée sur les microcontrôleurs

Le Tiny Machine Learning (TinyML) est l'application de l'apprentissage automatique à des dispositifs de faible puissance et de petite taille, comme les microcontrôleurs. L'ajout d'une intelligence artificielle à du matériel embarqué doté d'une puissance de calcul limitée le rend plus intelligent sans coûts supplémentaires liés à l'infrastructure ou à l'informatique dans le cloud.

En résumé, l'informatique périphérique ouvre la voie à davantage d'applications en temps réel dans l'industrie (de transformation), mais pas seulement.

En collaboration avec Danfoss, Emerson, Lenze et Phoenix Contact